Tout comprendre des LLMs (Large language models) et de leur fonctionnement

Les Large Language Models (LLMs) sont au cœur de la révolution IA actuelle. Propulsés par les avancées en deep learning, ces modèles comme GPT-4 ou Mistral 7B sont capables de comprendre, générer et traduire du texte avec une aisance bluffante. Leur montée en puissance, notamment depuis la sortie de ChatGPT, a marqué un tournant décisif dans l’adoption massive de l’IA.

Mais concrètement, c’est quoi un LLM ? Comment ça fonctionne, et quelles sont leurs limites ? Pour bien comprendre, un petit détour par les fondamentaux du deep learning peut être utile. On vous explique tout, simplement.

Définition des Large Language Models (LLM)

Qu’est-ce qu’un Large Language Model ?

Un Large Language Model (LLM), également connu sous le nom de grand modèle de langage, est une forme avancée de modèle d’intelligence artificielle (IA) spécialisée dans le traitement du langage naturel (TLN). Les LLM sont essentiellement des réseaux neuronaux profonds, qui ont la capacité de comprendre, interpréter et générer du langage humain.

Ils sont dits “grands” ou “larges” en raison du volume considérable de données utilisées pour leur entraînement. Les LLM sont souvent basés sur des architectures dites de “transformateurs” et sont formés sur des ensembles de données textuelles immenses, allant de la littérature aux contenus en ligne, en passant par l’actualité et les réseaux sociaux.

En raison de leur taille et de leur complexité, les LLM peuvent accomplir une variété de tâches liées au langage naturel, allant de la génération et la classification de texte, à la réponse à des questions de manière conversationnelle et la traduction de texte d’une langue à une autre. Parmi les LLMs les plus populaires on retrouve :

-

GPT-4 (Generative Pre-trained Transformer 4) : Développé par OpenAI, GPT-4 est l’une des versions les plus récentes et avancées de la série GPT. C’est le modèle qui alimente Chatgpt mais aussi Copilot de Microsoft et de très nombreux outils IA spécialisés.

-

Mistral 7B : Développé par Mistral AI, une start-up française. C’est un modèle de langage conçu pour offrir des performances élevées avec une architecture optimisée. Il est capable de traiter et de générer du texte de manière efficace, même avec un nombre relativement réduit de paramètres (7 milliards). De plus, Mistral 7B est open source, ce qui est un argument de vente important pour des clients qui souhaiteraient héberger le modèle chez eux.

-

LLaMA 3 (Large Language Model Meta AI 3) : Développé par Meta (anciennement Facebook), LLaMA 3 est la troisième version de la série LLaMA. Il est conçu pour proposer un niveau de performance élevé et est très apprécié de par son caractère Open Source.

-

Claude : Développé par Anthropic, Claude est une série de modèles de langage conçus pour être plus sûrs et alignés sur les valeurs humaines. Initialement introduit avec Claude 2, le modèle s’est distingué par sa capacité à comprendre et générer du texte de manière éthique et responsable, tout en offrant des performances élevées. Une caractéristique notable est sa capacité à gérer un contexte beaucoup plus large que la plupart de ses concurrents, ce qui lui permet de traiter des conversations longues et complexes de façon cohérente. La dernière version en date, Claude 3.7 Sonnet, pousse encore plus loin ces capacités, en combinant puissance, rapidité et une meilleure compréhension contextuelle.

Terminologie et concepts clés pour briller en société

Le monde de la technologie et du digital n’est pas avare en jargon. Mais le monde de l’IA est probablement le champion incontesté en la matière alors voici un récapitulatif des termes les plus importants à comprendre quand on parle de LLM.

C’est parti :

-

Modèle de langage : Un type de modèle d’intelligence artificielle conçu pour comprendre et générer du texte en langage naturel.

-

Entraînement : La phase où le modèle est formé sur de vastes ensembles de données générales pour apprendre les structures linguistiques de base.

-

Zero-shot Learning : La capacité d’un modèle à effectuer une tâche pour laquelle il n’a pas été spécifiquement entraîné, en utilisant ses connaissances générales.

-

Prompt : Le texte d’entrée fourni à un modèle de langage pour obtenir une réponse. La formulation du prompt peut fortement influencer la qualité de la réponse générée.

-

Paramètre : Une valeur ajustable dans un modèle de langage qui est modifiée durant l’entraînement pour améliorer les performances du modèle. Les LLM peuvent avoir des milliards de paramètres.

-

Transformer (transformateur): Une architecture de modèle qui utilise des mécanismes d’attention pour traiter et comprendre le texte. C’est la base des modèles modernes comme GPT-4.

-

Attention : Un mécanisme qui permet au modèle de se concentrer sur les parties les plus importantes du texte pour mieux comprendre le contexte.

-

Token (jeton) : Une unité de texte, comme un mot ou une partie d’un mot, que le modèle analyse et traite pour comprendre et générer des phrases.

-

Masque : Un mécanisme utilisé pour guider le modèle sur quelles parties du texte il doit se concentrer ou ignorer.

-

Fine-tuning : L’ajustement d’un modèle pré-entraîné sur des données spécifiques à une tâche particulière pour améliorer ses performances sur cette tâche.

Avec ça vous serez incollables, ou presque !

Applications et utilisations des LLM

Les applications des LLM sont très nombreuses, touchant tous les secteurs et provoquant une véritable révolution dans la plupart d’entre eux. Les LLMs sont utilisés massivement dans le marketing, le développement web, les services clients, la création audiovisuelle, et bien d’autres domaines. Plus concrètement, voici quelques applications fréquentes des LLMs :

-

Les assistants virtuels : Les LLMs sont utilisés pour développer des assistants virtuels capables de répondre à des questions, fournir des informations et assister les utilisateurs dans diverses tâches. Dans le cas de l’utilisation par les entreprises, l’utilisation d’un RAG peut en plus entraîner un assistant virtuel spécifiquement sur les données internes.

-

Chatbots : Ils alimentent des chatbots avancés qui peuvent engager des conversations naturelles avec les utilisateurs, aidant ainsi au service client et à l’engagement utilisateur.

-

Outils de rédaction : Les LLMs aident à la rédaction automatique de textes, que ce soit pour des e-mails, des articles, des rapports ou des récits créatifs, en prolongeant les idées et en apportant de la cohérence au texte.

-

Traduction automatique : En comprenant le contexte des phrases, les LLMs peuvent traduire du texte d’une langue à une autre tout en conservant le sens et le style original. Certains outils utilisent les capacités des LLMs pour traduire des vidéos, allant jusqu’à modifier l’image pour assurer une synchronisation labiale pour chaque langue.

-

Réponse à des questions : Ils sont capables de répondre à des questions en utilisant les informations qu’ils ont apprises, fournissant ainsi des réponses précises et informées.

-

Classification des documents ou informations : Une application technique des LLMs est la classification automatique des documents ou des informations. Cette tâche se fait souvent en arrière-plan sur un serveur ou via une API et est extrêmement utile pour tagger des demandes utilisateurs, leur associer une criticité, etc.

-

Parsing de sites web : Le parsing de sites web est grandement facilité par les LLMs, car l’IA “comprend” le contenu du site, y compris à partir d’images. C’est une véritable révolution dans ce domaine.

-

Transformation de données : Les LLMs peuvent transformer des données déconstruites ou dans un certain format (par exemple, un tableau Excel ou une réponse API) vers un nouveau format (comme JSON), facilitant ainsi l’intégration et l’utilisation des données.

Il y a bien d’autres usages aujourd’hui, et de nouveaux sont inventés presque tous les jours. Comprendre les LLMs est donc devenu une compétence clé, car leur utilisation se répandra de plus en plus dans divers domaines.

Fonctionnement des Large Language Models (LLMs)

Principe de Fonctionnement d’un LLM

Le fonctionnement des LLM repose sur une série de principes fondamentaux du Machine Learning et des architectures neuronales. Le premier pas dans ce processus est l’entraînement. Les LLM sont entraînés sur des corpus de texte gigantesques, souvent composés de trillion de mots.

Durant l’apprentissage, les LLM prennent des séquences de texte en entrée et génèrent des prédictions basées sur le contexte. Ils utilisent pour ce faire des masques et des token (jetons). Le modèle est ensuite capable de générer des textes semblables à ceux qu’il a appris, en capturant le contexte, le ton, les nuances et même les éléments culturels du langage.

C’est cette capacité à identifier le sens d’une phrase (et non pas “comprendre”) et générer des textes cohérents à sa suite qui rend les LLMs si efficaces pour des tâches aussi variées que la rédaction de textes, la traduction en plusieurs langues ou encore la conduite de conversations.

C’est donc finalement, et dit très grossièrement, une question de probabilité. Un LLM ne comprend pas vraiment ce que vous lui dites, ni ce qu’il vous répond, mais il peut très probablement fournir la réponse que vous recherchez.

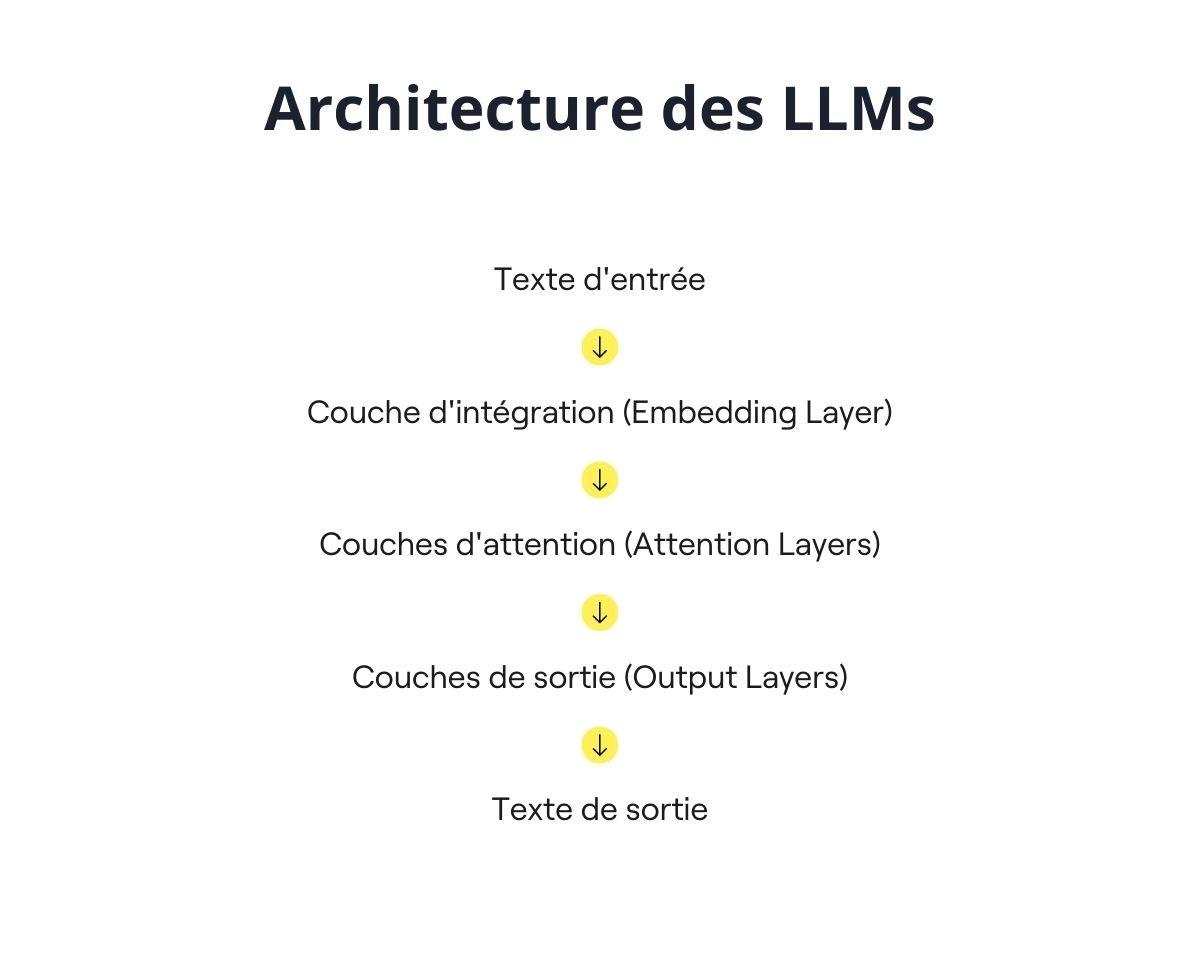

L’architecture des LLMs

Quand on parle d’architecture, on parle des principes techniques qui permettent aux LLMs de fonctionner.

L’architecture des LLMs est généralement basée sur des modèles de transformateurs, qui sont des réseaux de neurones profonds. Ils comprennent plusieurs éléments clefs dont :

-

Les couches d’intégration (embeddings) : Ces couches transforment les mots en vecteurs numériques, permettant aux modèles d’analyser les données textuelles.

-

Les couches d’attention : Elles permettent au modèle de se concentrer sur les parties pertinentes d’un texte lors de la génération de réponses.

-

Les couches de sortie (output layers) : Elles génèrent les prédictions finales du modèle.

Les LLMs possèdent un grand nombre de paramètres, qui sont des valeurs ajustables dans le modèle. Ces paramètres sont modifiés durant l’entraînement pour améliorer les performances du modèle. L’architecture des LLMs peut varier en taille, avec des modèles allant de quelques millions à des centaines de milliards de paramètres. Plus le nombre de paramètres est élevé, plus le modèle est capable de réaliser des tâches complexes et de produire des réponses précises et pertinentes.

Cette précision a un coût, puisque le nombre de paramètres et la taille du modèle ont un impact sur la puissance de calcul nécessaire pour faire fonctionner ce modèle. De plus, le nombre de paramètres influence également le processus de fine-tuning. Le fine-tuning consiste à ajuster un modèle pré-entraîné sur un ensemble de données spécifique pour une tâche particulière, et un modèle avec un grand nombre de paramètres peut nécessiter plus de ressources et de temps pour ce processus.

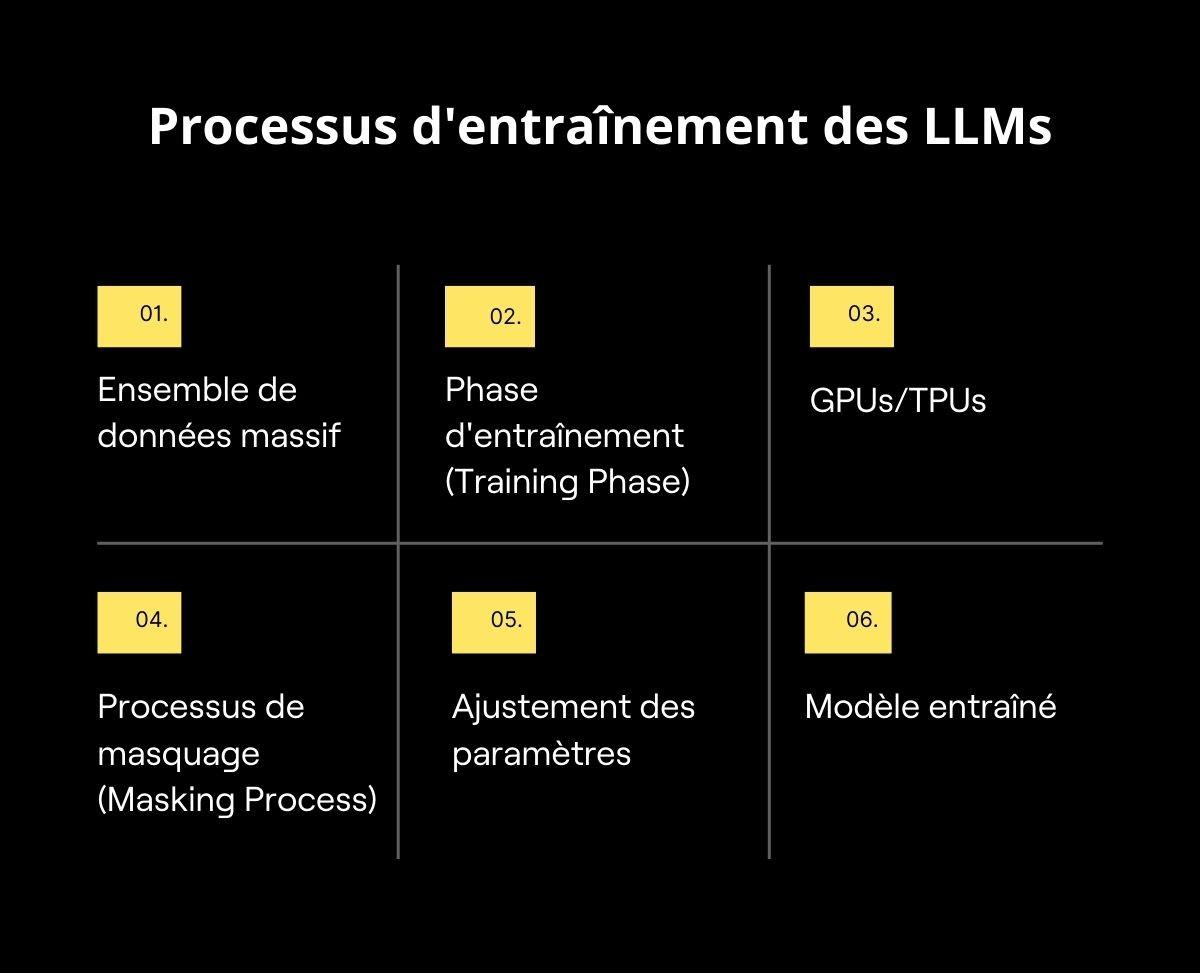

Comment sont-ils entraînés ?

L’entraînement des LLM se fait à travers un processus appelé apprentissage supervisé. Durant cette phase, les modèles sont alimentés par d’immenses ensembles de données textuelles, comprenant des milliers de milliards de mots et de phrases. Ces données servent d’exemples pour le modèle, qui apprend à prédire le mot suivant dans une phrase en se basant sur le contexte fourni par les mots précédents.

Les LLM utilisent une technique spécifique appelée masquage, qui consiste à cacher certains mots dans une phrase et à demander au modèle de les prédire. Cette méthode permet aux LLM de comprendre les relations entre les mots et d’apprendre la structure du langage.

En termes de matériel, l’entraînement des Large Language Models nécessite des ressources informatiques considérables, avec des processeurs graphiques hautement performants. C’est un processus qui peut prendre plusieurs semaines, voire des mois, en fonction de la taille du modèle et de la quantité de données à traiter.

C’est également l’entraînement qui pose de nombreuses questions d’éthique aujourd’hui, les développeurs de LLM étant très évasifs sur la source des données qui ont servi à l’entraînement et dans quelle mesure cela pourrait enfreindre les règles de la propriété intellectuelle.

Performance et évaluation

Bien entendu on ne fait pas une confiance aveugle à l’entraînement des LLMs, pour les affiner et les évaluer on va utiliser des méthodes d’évaluation de leur performance. Ces méthodes vont mesurer plusieurs métriques de performance, notamment :

La perplexité

La perplexité évalue la capacité d’un modèle à prédire une séquence de mots. Plus la perplexité est basse, meilleure est la prédiction du modèle, indiquant une meilleure compréhension du texte.

L’exactitude (Accuracy)

L’exactitude mesure le pourcentage de prédictions correctes effectuées par le modèle. Bien qu’elle soit couramment utilisée pour les tâches de classification, elle s’applique aussi aux tâches de traitement du langage naturel comme la classification de texte.

Le F1-Score

Le F1-score combine deux aspects importants : la précision et le rappel. La précision indique le pourcentage de prédictions correctes parmi celles faites par le modèle, tandis que le rappel montre le pourcentage des éléments corrects qui ont été identifiés par le modèle.

BLEU (Bilingual Evaluation Understudy)

Le score BLEU compare la qualité du texte généré par le modèle à des références humaines. Principalement utilisé pour évaluer les systèmes de traduction automatique, un score BLEU élevé indique une forte similarité avec les traductions humaines.

ROUGE (Recall-Oriented Understudy for Gisting Evaluation)

Le score ROUGE mesure la qualité des résumés automatiques en comparant les chevauchements de n-grammes avec des résumés de référence. En d’autres termes, ROUGE évalue dans quelle mesure le résumé généré par le modèle correspond aux résumés créés par des humains. Un score ROUGE élevé indique que le modèle a bien capturé les points clés et l’essence du texte source.

Défis et perspectives des Large Language Models

Limites actuelles des LLM

Ne nous voilons pas la face, les LLMs ont aussi leur limite à l’heure actuelle.

Bien que très impressionnants, les LLMs ont aussi leurs limites à l’heure actuelle. Sur le plan éthique, les LLM peuvent reproduire et amplifier les biais présents dans les données d’entraînement, conduisant à des résultats discriminatoires ou non éthiques. Par exemple, des modèles comme GPT-4 ont montré des biais de genre et de race dans leurs réponses. De plus, l’entraînement de ces modèles nécessite des ressources informatiques considérables, entraînant une consommation d’énergie élevée. Cela soulève des préoccupations environnementales importantes, car les centres de données utilisés pour entraîner ces modèles contribuent de manière significative aux émissions de carbone.

Les LLM font également face à des problèmes de scalabilité et de coûts. À mesure que les modèles de langage deviennent plus grands, les besoins en termes de calcul et de mémoire augmentent de manière exponentielle, rendant difficile l’entraînement et le déploiement de modèles extrêmement volumineux. Les coûts associés à l’entraînement des LLM sont élevés en raison de la nécessité de matériel spécialisé comme les GPU et des infrastructures robustes. La consommation énergétique considérable requise pour un entraînement continu sur des corpus massifs de données est aussi une problématique de coûts importante.

Un autre exemple de limitation des LLM se manifeste dans la génération de textes trop génériques pour être utilisables efficacement par les professionnels. Les LLM ont tendance à produire des réponses qui manquent de spécificité et de précision contextuelle. Néanmoins, des techniques avancées comme le Retrieval-Augmented Generation (RAG) peuvent outrepasser cette limite et produire des réponses bien plus efficaces dans un contexte donné.

Les LLMs absorbent également du contenu protégé ou sans autorisation, ce qui pose des problèmes de droits d’auteur. Un exemple notable est la poursuite en justice intentée par le New York Times contre OpenAI et Microsoft pour violation de droits d’auteur.

Solutions possibles

Pour surmonter certaines de ces limitations, plusieurs solutions sont envisagées :

-

Modèles plus petits et plus spécialisés : Des modèles comme Mistral sont conçus pour offrir des performances élevées avec une architecture optimisée et un nombre réduit de paramètres, ce qui les rend moins gourmands en ressources.

-

Modèles fonctionnant en local : L’utilisation de NPU (Neural Processing Unit) sur les appareils des utilisateurs permet de faire tourner des modèles en local, réduisant ainsi la consommation d’énergie et augmentant la sécurité.

En conclusion, bien que les LLMs soient incroyablement puissants et polyvalents, il est crucial de continuer à développer des solutions pour atténuer leurs limitations actuelles et maximiser leurs avantages de manière éthique et durable.

Innovations et améliorations en cours

Les LLMs sont en constante évolution, avec des efforts de recherche en cours pour améliorer leur performance, leur fiabilité et leur accessibilité. Les domaines clés de l’innovation incluent :

-

Optimisation des ressources : Des avancées sont réalisées pour réduire la consommation d’énergie et les coûts associés à l’entraînement des LLM. On travaille notamment sur une augmentation de l’efficacité des unités de traitement comme les GPU et les TPU.

-

Apprentissage par renforcement avec rétroaction humaine (RLHF) : L’RLHF est une méthode en cours d’exploration pour améliorer l’apprentissage des LLM. Il s’agit d’un processus itératif qui vise à rendre les réponses du LLM plus alignées avec les attentes d’un utilisateur humain.

-

Open source : La tendance vers l’open source et la compétition ouverte permet aux chercheurs du monde entier de contribuer à l’amélioration des LLM. Cette démocratisation de la recherche devrait permettre des avancées plus rapides et plus accessibles à tous.

Attention toutefois, on entend beaucoup parler dans les médias d’un concept : L’AGI (intelligence artificielle générale). On en est encore assez loin et les experts doutent que les technologies actuellement utilisées par les LLMs permettent d’atteindre des IA si avancées. Mais les innovations actuellement suffisent à rendre les LLMs incontournables pour les entreprises. Elles ont tout intérêt à capitaliser sur cette technologie en s’appuyant sur le RAG et d’autres méthodes d’orchestration pour créer un avantage compétitif très significatif et sortir grandies de la révolution en cours.