MCP : la clé pour rendre un logiciel vraiment intelligent

Vous avez une idée de SaaS propulsé par l’IA. Peut-être un copilote pour automatiser la veille concurrentielle, un assistant qui génère des propositions commerciales sur mesure, ou un outil d’analyse qui transforme des données brutes en insights actionnables. La question qui se pose immédiatement : par où commencer ? Quelle architecture ? Quelles technologies ? Et surtout : comment éviter de construire un prototype impressionnant qui ne passera jamais en production ?

Si vous construisez ce produit aujourd’hui, ignorer le Model Context Protocol serait une erreur stratégique majeure. Non pas parce que c’est la tendance du moment, mais parce que MCP change fondamentalement la façon dont on conçoit un SaaS IA : de l’architecture monolithique qui réinvente la roue, vers un système intelligent qui compose les meilleurs services disponibles. Décryptage des choix critiques, des pièges à éviter, et de la roadmap pour passer de l’idée au produit scalable.

Ce qu’il faut retenir sur les MCP dans un SaaS IA :

Construire un SaaS IA en 2025, c’est avant tout orchestrer : la valeur n’est plus dans “tout développer en interne”, mais dans un orchestrateur intelligent qui compose les meilleurs services via MCP.

L’approche MCP-first réduit la dette technique : vous exposez vos briques métier en services MCP, vous pluggez des outils tiers pour le reste, et vous gardez la liberté de changer de fournisseurs sans tout réécrire.

RAG, fine-tuning et prompting avancé ne s’opposent pas : les SaaS IA les plus robustes combinent les trois, chaque approche étant encapsulée dans un service que l’orchestrateur active selon le besoin.

La gestion des coûts d’inférence se décide dans l’architecture : routage vers des modèles légers, caching, compression de contexte et batchs permettent de diviser la facture par 5 à 10 sans sacrifier l’UX.

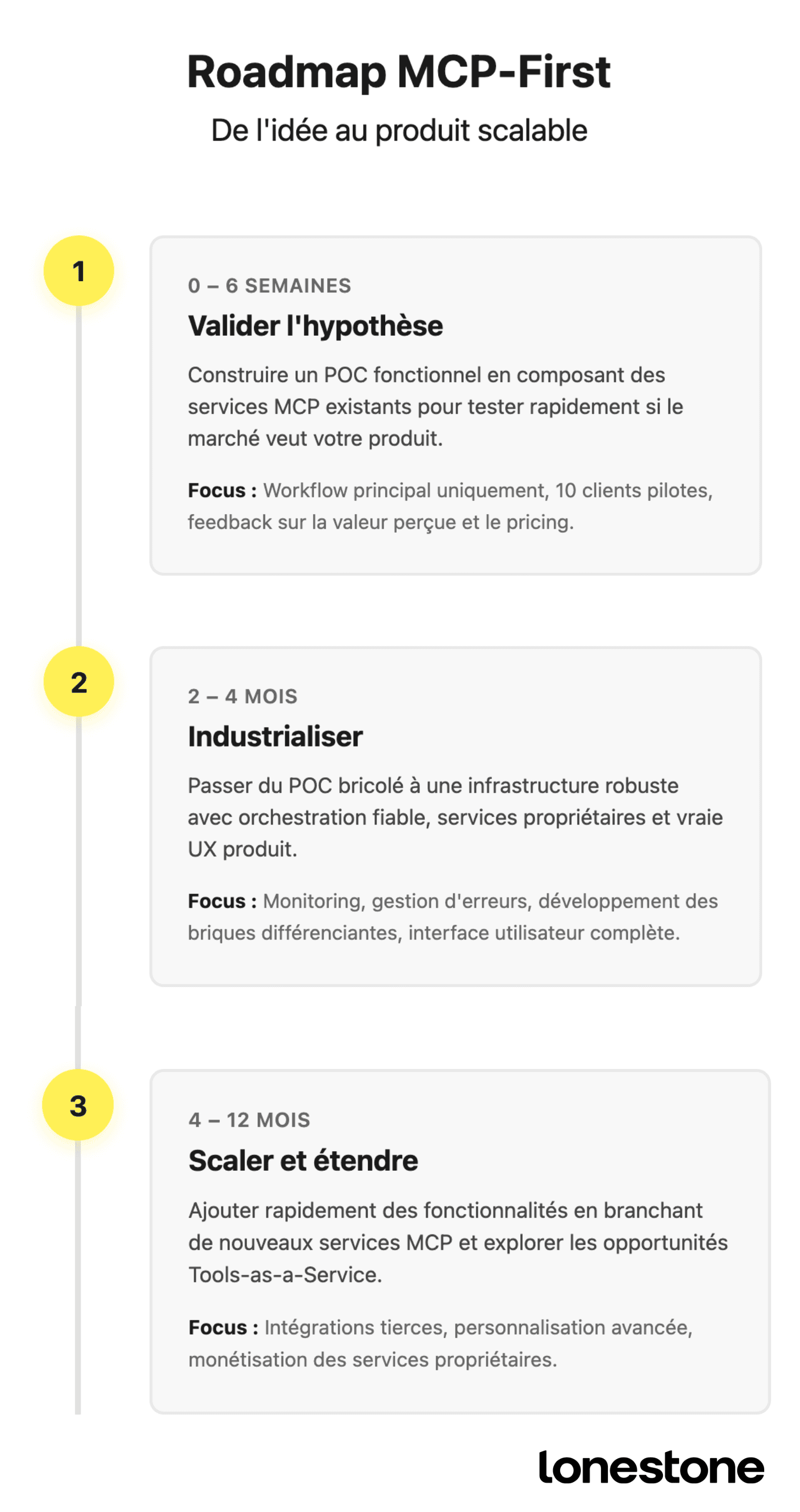

La bonne roadmap, c’est POC MCP-first → fondations solides → scale : valider l’hypothèse en 4–6 semaines, industrialiser l’orchestration et les services propriétaires, puis étendre les usages sans exploser les coûts ni la complexité.

Repenser l’architecture : de “tout faire” à “tout orchestrer”

Le piège de l’application monolithique IA

Quand on se lance dans la construction d’un SaaS IA, le réflexe naturel est de vouloir tout contrôler. Vous allez développer votre propre système de scraping, votre base vectorielle, votre moteur de génération, votre système d’authentification, vos connecteurs vers les outils tiers. Résultat : neuf mois de développement, une dette technique considérable, et un produit qui fait beaucoup de choses moyennement bien.

L’approche MCP-first inverse complètement cette logique. Vous ne construisez pas une application qui fait tout, mais un orchestrateur intelligent qui compose les meilleurs services disponibles pour chaque tâche. Votre valeur ajoutée ne réside plus dans la réimplémentation de briques génériques, mais dans trois éléments critiques :

-

La compréhension de l’intention : votre agent sait interpréter ce que veut vraiment l’utilisateur, même quand la demande est vague ou incomplète. Un directeur innovation qui demande “prépare-moi une analyse de la concurrence” n’a pas besoin de spécifier s’il veut du scraping web, de l’analyse de sentiment, ou une synthèse financière.

-

La composition intelligente : face à une intention donnée, votre système sait quels services mobiliser, dans quel ordre, avec quels paramètres. Deux SaaS peuvent utiliser les mêmes services MCP externes, mais la qualité d’orchestration fera toute la différence.

-

L’apprentissage continu : votre orchestrateur s’améliore avec l’usage. Il mémorise les patterns qui fonctionnent, détecte les services qui produisent de meilleurs résultats, optimise les coûts en cachant intelligemment, et s’adapte aux préférences de chaque utilisateur.

Architecture type d’un SaaS MCP-native

Concrètement, un SaaS IA pensé MCP-first s’articule autour de quatre couches distinctes :

L’interface conversationnelle où l’utilisateur exprime ses intentions en langage naturel. Pas de formulaire complexe avec quinze champs obligatoires, juste une conversation fluide qui guide progressivement vers la précision nécessaire.

L’orchestrateur central – le cerveau du système. C’est lui qui interprète l’intention, détermine le workflow optimal, gère le contexte conversationnel, et coordonne les appels aux différents services. Il doit aussi gérer les erreurs gracieusement : si un service externe est temporairement indisponible, il bascule vers une alternative plutôt que de tout planter.

Les services MCP externes : scraping, enrichissement de données, analyse, génération de contenu, mise en forme. Vous les sélectionnez selon trois critères (fiabilité, coût, qualité) et vous restez prêt à en changer si un concurrent fait mieux.

Vos services propriétaires – ceux qui constituent votre secret sauce. C’est peut-être votre base de connaissances métier accumulée, votre système de scoring spécifique à votre secteur, ou votre algorithme de recommandation entraîné sur vos données. Vous les développez vous-même et les exposez via MCP pour qu’ils s’intègrent naturellement dans l’orchestration globale.

Chez Lonestone, notre stack type pour un nouveau SaaS IA comprend :

Orchestration : LangGraph ou Semantic Kernel pour gérer les workflows complexes avec gestion d’état, retry logic et branchements conditionnels

LLM : Claude Sonnet 4 pour l’orchestration (excellent reasoning) + Haiku pour les tâches simples (ratio coût/performance optimal)

Bases de données : PostgreSQL + pgvector pour la recherche sémantique, Redis pour le caching des appels coûteux

Observabilité : LangSmith ou Helicone pour tracer chaque requête, mesurer latences et coûts, identifier les goulots d’étranglement

Infrastructure : Railway ou Render pour déployer rapidement les premiers serveurs MCP, Cloudflare Workers pour les fonctions edge critiques en latence

Les décisions architecturales critiques pour un SaaS MCP

RAG, fine-tuning ou prompting avancé ?

Dès que vous commencez à construire un SaaS IA qui doit manipuler des connaissances spécifiques (documentations techniques, historiques de conversations, données métier), la question se pose : comment injecter cette connaissance dans le système ?

Le Retrieval Augmented Generation (RAG) est souvent la bonne réponse pour démarrer. Vous indexez vos documents dans une base vectorielle, et au moment où l’utilisateur pose une question, vous récupérez les passages pertinents que vous injectez dans le contexte du LLM. L’avantage : c’est rapide à mettre en place, ça fonctionne avec n’importe quel LLM, et vous pouvez mettre à jour les connaissances en temps réel sans réentraînement.

Mais le RAG n’est pas toujours la solution. Si votre SaaS doit reproduire un style d’écriture très spécifique (ton de voix corporate, format de rapport standardisé), ou s’il doit apprendre des patterns métier complexes qui nécessitent beaucoup d’exemples, le fine-tuning devient pertinent. Vous entraînez un modèle spécifiquement sur vos cas d’usage, et il “comprend” nativement ce que vous attendez sans avoir besoin de tout réexpliquer à chaque requête.

La troisième voie, souvent sous-estimée, c’est le prompting avancé avec few-shot learning. Vous maintenez une bibliothèque d’exemples de qualité et vous injectez dynamiquement les plus pertinents dans le prompt selon le contexte. C’est moins sophistiqué techniquement, mais ça fonctionne remarquablement bien pour beaucoup de cas d’usage tout en restant très flexible.

En pratique, les meilleurs SaaS IA combinent ces trois approches. Un RAG pour les connaissances factuelles qui évoluent, fine-tuning pour les patterns métier stables, et prompting avancé pour la personnalisation contextuelle. L’architecture MCP rend cette hybridation naturelle : chaque approche peut être encapsulée dans un service différent que l’orchestrateur compose selon les besoins.

Concevoir pour la composition : le principe “MCP-ready”

Si vous voulez que votre SaaS puisse facilement intégrer de nouveaux services MCP à mesure qu’ils émergent, certains principes de conception changent dès le départ :

-

Pensez interfaces stables, implémentations variables : votre orchestrateur ne doit jamais appeler directement un service externe. Il appelle une interface abstraite (“analyser le sentiment”), et c’est une couche d’adaptation qui route vers le service concret. Demain, vous pourrez changer de fournisseur sans toucher à l’orchestrateur.

-

Standardisez vos schémas de données : tous vos services internes doivent parler le même langage (mêmes formats de dates, mêmes structures d’entités, mêmes codes d’erreur). Cette discipline évite les bugs vicieux où un service retourne un format que le suivant ne sait pas lire.

-

Documentez pour les agents, pas pour les humains : chaque service MCP que vous exposez doit inclure des descriptions ultra-précises. Les LLM ont besoin de cette précision pour utiliser correctement vos outils.

Gérer les coûts : la réalité économique de l’IA

Une erreur classique des premiers SaaS IA : sous-estimer drastiquement les coûts d’inférence. Vous construisez un prototype qui fonctionne à merveille avec dix utilisateurs test, puis vous découvrez en production que chaque requête coûte 0,50€ parce que vous envoyez des contextes énormes à GPT-4. Votre pricing à 29€/mois par utilisateur devient soudain intenable.

L’architecture MCP-first aide à gérer ce problème de trois manières :

-

Le routage intelligent entre modèles : les tâches simples (extraction d’informations, classification) vont vers des modèles légers et bon marché (Claude Haiku, GPT-4o-mini), les tâches complexes vers les modèles puissants.

-

Le caching agressif : beaucoup d’appels LLM sont redondants. Si dix utilisateurs demandent “résume ce document” sur le même PDF, vous ne devez pas payer dix fois l’inférence. Un bon système de cache peut diviser vos coûts par trois.

-

La compression contextuelle : avant d’envoyer un contexte au LLM, vous le prétraitez pour ne garder que l’essentiel. Un document de 50 pages peut souvent être résumé en 3 pages pertinentes, divisant par quinze le coût de tokenisation.

Quelques techniques concrètes que nous implémentons systématiquement :

Prompt caching : Claude propose du caching natif pour les grands contextes répétés (documentation, historique). Coût divisé par 10 sur les tokens en cache.

Semantic chunking : découper intelligemment les documents selon le sens plutôt que par taille fixe. Améliore la pertinence du RAG et réduit le contexte nécessaire.

Batch processing : grouper les requêtes non-urgentes pour utiliser les APIs batch 50% moins chères.

Fallback graduel : tenter d’abord avec un modèle léger, et escalader vers un modèle puissant seulement si la qualité est insuffisante.

Ces optimisations permettent souvent de diviser les coûts par 5 à 10 sans sacrifier l’expérience utilisateur.

De l’idée au produit : la roadmap MCP-first

Phase 0-6 semaines : valider l’hypothèse avec un POC MCP-first

La première erreur serait de passer six mois à construire avant de tester si quelqu’un veut vraiment votre produit. L’approche MCP-first permet de valider très rapidement l’hypothèse centrale. Vous identifiez le workflow principal de votre SaaS (celui qui délivre 80% de la valeur), et vous le construisez en composant des services existants.

Exemple concret : vous voulez créer un SaaS qui automatise la veille concurrentielle. Votre workflow MVP compose quatre briques : scraping des sites concurrents et actualités secteur (Firecrawl MCP), extraction des informations clés (Claude avec RAG sur historique), génération d’un brief synthétique personnalisé (prompts optimisés + templating), et envoi automatisé par email ou Slack.

Avec cette approche, vous pouvez avoir un POC fonctionnel en quatre à six semaines et le tester avec dix clients pilotes. Leur feedback vous dira si le concept tient la route, quels ajustements sont nécessaires, et si le pricing envisagé a du sens par rapport à la valeur perçue.

Phase 2-4 mois : construire des fondations robustes pour un SaaS MCP-native

Une fois le concept validé, il faut industrialiser. C’est là que beaucoup de startups IA déraillent : elles essaient de scaler le POC tel quel et se heurtent à des problèmes de fiabilité, de coûts explosifs, ou de dégradation de la qualité.

L’industrialisation passe par trois chantiers parallèles :

-

L’infrastructure d’orchestration : vous remplacez les scripts bricolés par un système robuste avec gestion d’erreurs, retry logic, monitoring des performances, alertes proactives. Vous implémentez l’observabilité qui vous permettra de comprendre ce qui se passe en production.

-

Les services propriétaires : vous identifiez les parties de votre workflow où les services génériques ne suffisent plus. Ces briques-là, vous les développez en interne et vous les exposez comme des serveurs MCP que votre orchestrateur peut utiliser.

-

L’expérience utilisateur : vous passez de l’interface de démo à une vraie interface produit. Comment l’utilisateur configure ses préférences ? Comment il visualise l’historique ? Comment il corrige une erreur de l’agent ? Ces questions deviennent critiques en production.

Phase 4-12 mois : scaler et étendre les usages dans une architecture MCP

C’est dans cette phase que l’architecture MCP-first révèle tout son potentiel. Vous commencez à recevoir des demandes de fonctionnalités que vous n’aviez pas anticipées. Avec une architecture monolithique, chacune nécessiterait des semaines de développement. Avec MCP, vous cherchez d’abord si un service existant peut répondre au besoin.

Vos utilisateurs demandent l’intégration avec leur CRM ? Vous branchez un connecteur MCP existant plutôt que de développer une intégration custom pour chaque CRM. Ils veulent des analyses plus poussées ? Vous testez trois services d’analytics différents et vous gardez celui qui donne les meilleurs résultats. Ils réclament l’export en PowerPoint avec leur charte graphique ? Un service de templating avancé résout ça en deux jours.

Mais surtout, vous commencez à voir des opportunités auxquelles vous n’aviez pas pensé au départ. Votre service propriétaire de scoring des actualités secteur, vous pourriez le proposer à d’autres SaaS comme un Tools-as-a-Service. Vos utilisateurs power users demandent à créer leurs propres workflows personnalisés ? Vous transformez votre orchestrateur en plateforme où ils peuvent composer eux-mêmes des agents spécialisés.

Cette évolution de “produit” vers “plateforme” est naturelle dans une architecture MCP. Et c’est souvent là que les métriques de croissance s’accélèrent vraiment.

Construire un SaaS IA en 2025, ce n’est plus construire une application qui fait tout. C’est construire un système intelligent qui compose les meilleurs services disponibles pour créer une expérience utilisateur exceptionnelle. MCP n’est pas qu’un protocole technique : c’est un changement de paradigme dans la façon de concevoir, développer et faire évoluer un produit numérique piloté par l’intelligence artificielle.

Chez Lonestone, nous accompagnons des fondateurs et des équipes innovation dans cette transformation – du choix d’architecture initial jusqu’à l’implémentation complète et le passage en production. Parce que construire un SaaS IA robuste nécessite bien plus qu’une bonne idée : il faut la bonne architecture, les bons arbitrages techniques, et une équipe qui maîtrise aussi bien la stratégie produit que le design d’expérience et le développement.

La question n’est plus de savoir si MCP va s’imposer – il s’impose déjà. La vraie question : allez-vous construire votre produit en mode MCP-first dès le départ, ou passer deux ans à accumuler de la dette technique avant de devoir tout refactoriser ? Les pionniers font ce choix maintenant. Et vous ?